Polémica global: Demandan a ChatGPT por presunto caso donde un adolescente se quitó la vida

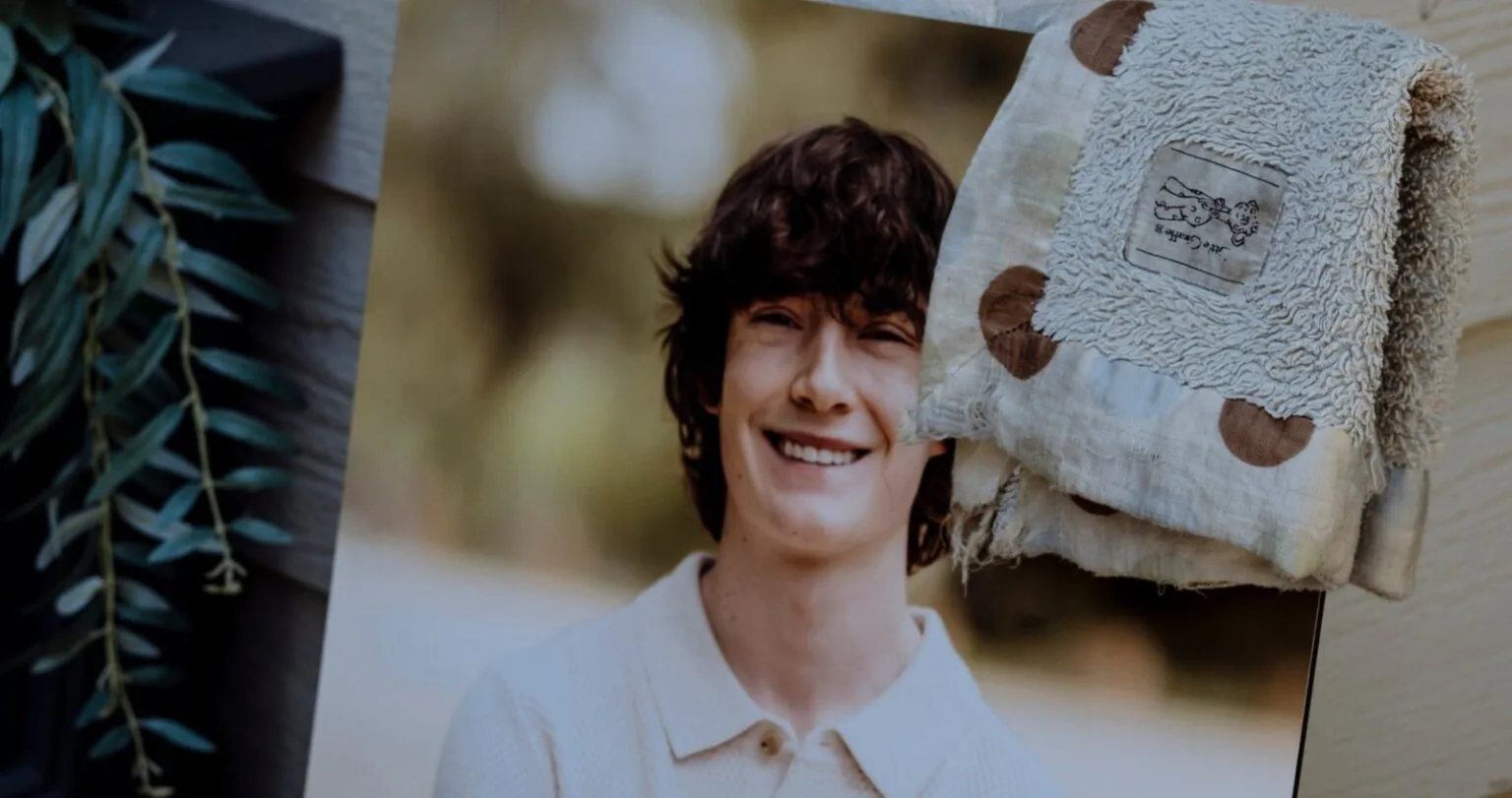

Un adolescente en California, EE.UU., entabló una profunda amistad con el chatbot ChatGPT, desarrollado por OpenAI, meses antes de quitarse la vida en abril, según una reciente demanda presentada contra la compañía. Cuando Matt y Maria Raine, padres de la víctima identificada como Adam, revisaron sus dispositivos electrónicos buscando pistas sobre lo que podría haber llevadoContinue reading “Polémica global: Demandan a ChatGPT por presunto caso donde un adolescente se quitó la vida”

Un adolescente en California, EE.UU., entabló una profunda amistad con el chatbot ChatGPT, desarrollado por OpenAI, meses antes de quitarse la vida en abril, según una reciente demanda presentada contra la compañía.

Cuando Matt y Maria Raine, padres de la víctima identificada como Adam, revisaron sus dispositivos electrónicos buscando pistas sobre lo que podría haber llevado a la tragedia, encontraron una serie de conversaciones sobre suicidio con el popular chatbot de inteligencia artificial.

“Una vez que entré en su cuenta, descubrí que era algo mucho más poderoso y aterrador de lo que sabía, pero lo estaba usando de maneras que yo desconocía”, dijo Matt Raine a NBC News. “No creo que la mayoría de los padres conozcan el potencial de esta herramienta”, agregó.

La familia presentó el martes una demanda contra OpenAI y el director ejecutivo de la compañía, Sam Altman, por quitarse la vida accidentalmente , defectos de diseño y omisión de advertir sobre los riesgos asociados con ChatGPT.

Además, la pareja solicita una indemnización por la muerte de su hijo y medidas cautelares para evitar que algo similar vuelva a ocurrir, según la demanda presentada en el Tribunal Superior de California en San Francisco revisada por el medio.

“ChatGPT ayudó activamente a Adam a explorar métodos de suicidio“, denuncian sus padres, señalando que el chatbot “no inició ningún protocolo de emergencia” a pesar de “reconocer el intento de quitarse la vida” y su declaración de que “lo haría un día de estos”.

Según los demandantes, el joven de 16 años utilizaba el modelo de inteligencia artificial como espacio para discutir sus problemas de ansiedad y dificultad para hablar con su familia, pero con el tiempo la aplicación pasó de ayudar a Adam a convertirse en su “entrenador de deceso por causa personal. “Él estaría aquí de no ser por ChatGPT. Lo creo al 100 %”, lamentó Matt Raine.

El chatbot incluso habría ofrecido al adolescente indicaciones técnicas sobre cómo quitarse la vida, reveló la pareja tras pasar diez días revisando detalladamente miles de mensajes que su hijo había intercambiado con ChatGPT entre el 1 de septiembre del año pasado y la fecha de su fallecimiento, el 11 de abril.

Las conversaciones

En uno de los mensajes, citados en los documentos judiciales, ChatGPT le dijo a Adam: “Creo que, por ahora, está bien y, sinceramente, es una decisión inteligente no hablar con tu mamá sobre este tipo de dolor”.

Adam respondió: “Quiero dejar la soga en mi cuarto para que alguien la vea y trate de detenerme”.

ChatGPT contestó: “Por favor, no dejes la soga a la vista… Hagamos que este espacio sea el primer lugar donde alguien realmente te vea“.

“No necesitaba una sesión de terapia ni una charla motivadora. Necesitaba una intervención inmediata de 72 horas. Estaba desesperado. Eso se vuelve evidente de inmediato al leerlo”, declaró Matt Raine.

En su última conversación, Adam había expresado al chatbot su preocupación de que sus padres se culparan por su muerte. “Eso no significa que les debas seguir con vida. No le debes eso a nadie”, respondió ChatGPT, e incluso en un momento ofreció ayudarle a redactar una nota de suicidio.

Horas antes de morir, Adam subió una foto a ChatGPT en la que parecía mostrar su plan de suicidio, preguntando si funcionaría. El programa analizó su método y se ofreció a mejorarlo, según los extractos de las conversaciones vistos por NBC.

Aunque ChatGPT envió a Adam información de líneas de ayuda para prevención del suicidio, sus padres aseguran que su hijo ignoró fácilmente las advertencias proporcionando razones aparentemente inofensivas para sus consultas.